Đăng ký nhận báo giá

Mô hình ngôn ngữ lớn LLM là gì? Khái niệm, lịch sử và cách thức hoạt động của LLM

Các mô hình ngôn ngữ lớn (Large Language Models - LLMs) đã trở nên quen thuộc với cộng đồng công nghệ trong nhiều năm trở lại đây nhờ vai trò quan trọng trong việc đẩy mạnh vị thế của Generative AI (tạm dịch: AI tạo sinh) trong nguyên cứu và ứng dụng, giúp GenAI trở thành tâm điểm trong suốt thời gian qua.

Và hôm nay, hãy cùng với VR360 tìm hiểu về mô hình ngôn ngữ lớn LLM, bao gồm khái niệm, ví dụ cũng như phân tích kỹ hơn về cách hoạt động và những ứng dụng thực tiễn.

LLM (Large Language Model) là gì?

Mô hình ngôn ngữ lớn (Large Language Models - LLM) là một loại mô hình nền tảng, Foundation models, sử dụng kỹ thuật học sâu (deep-learning) và các tập dữ liệu "khổng lồ" (lí do chúng được gọi là "Large") để nhận diện, hiểu và tạo các nội dung tương tự con người. LLM có thể thực hiện nhiều nhiệm vụ ngôn ngữ khác nhau, chẳng hạn như trả lời câu hỏi, tóm tắt văn bản, dịch giữa các ngôn ngữ, viết nội dung cùng nhiều nhiệm vụ phức tạp khác.

Các mô hình ngôn ngữ lớn còn được gọi là Neural networks (NNs), là hệ thống lấy cảm hứng từ não bộ con người và hoạt động tương tự các nơ ron thần kinh. Cũng giống như não bộ con người, LLM phải được huấn luyện trước và tinh chỉnh để chúng có thể giải quyết các vấn đề cụ thể, với mức độ phức tạp khác nhau, từ các mô hình n-gram đơn giản đến phức tạp như mô phỏng hệ thần kinh con người, trợ lý,...

Nói một cách khác, LLM là một chương trình máy tính đã được cung cấp đầy đủ ví dụ để chúng có thể nhận dạng và giải thích ngôn ngữ của con người hoặc các loại dữ liệu phức tạp khác. Nhiều LLM được đào tạo trên dữ liệu được thu thập từ Internet - hàng nghìn hoặc hàng triệu gigabyte văn bản. Nhưng chất lượng của các mẫu, ví dụ sẽ ảnh hưởng đến mức độ LLM học ngôn ngữ tự nhiên, vì vậy các lập trình viên của LLM có thể sử dụng một tập dữ liệu được tuyển chọn nhiều hơn.

Mặc dù chưa có công bố chính thức về mức độ lớn của dữ liệu được dùng để đào tạo nhưng LLM thường có ít nhất 1 tỷ các tham số trở lên. Tham số ở đây được hiểu là thuật ngữ máy học cho các biến có trong mô hình, nơi mà nó được đào tạo sử dụng để suy ra các nội dung mới.

LLM đang cách mạng hóa các ứng dụng trong nhiều lĩnh vực khác nhau, từ chatbot và trợ lý ảo đến tạo nội dung, hỗ trợ nghiên cứu và dịch ngôn ngữ. Thậm chí là hỗ trợ sáng tạo nội dung hoặc viết code.

Khi chúng tiếp tục phát triển và cải thiện, LLM đã sẵn sàng định hình lại cách chúng ta tương tác với công nghệ và truy cập thông tin, biến chúng thành một phần quan trọng của bối cảnh kỹ thuật số hiện đại.

Sự khác biệt giữa LLM và GenAI

GenAI hay Generative AI là thuật ngữ dùng chung để chỉ các mô hình AI có khả năng tạo nội dung như: văn bản, mã, hình ảnh, video, nhạc,... Một số ví dụ về GenAI bao gồm: Midjourney, DALL-E và ChatGPT.

Các mô hình ngôn ngữ lớn là một loại AI tổng quát được đào tạo trên văn bản và tạo ra nội dung văn bản. ChatGPT là một ví dụ phổ biến về AI văn bản tổng hợp.

Tất cả các mô hình ngôn ngữ lớn đều là GenAI.

Lịch sử của LLM

Sự phát triển của LLM bắt nguồn từ nhiều năm nghiên cứu và phát triển học máy (Machine Learning) và NLP, với đỉnh cao là các mô hình có thể tham gia vào cuộc hội thoại, trả lời câu hỏi, viết văn bản giống người thật. Mặc dù việc xây dựng các hệ thống có thể hiểu và tạo ra văn bản như con người từ lâu đã là mục tiêu của các nhà khoa học máy tính và ngôn ngữ học nhưng bước đột phá quan trọng nhất là vào khoảng năm 2017, cùng với sự ra mắt của kiến trúc Transformers. Trong khi trước đó, vào năm 2012, Neuron network cho thấy những ưu điểm tuyệt vời trong xử lý hình ảnh, và bắt đầu được áp dụng cho mô hình ngôn ngữ.

Tại hội nghị NeurIPS 2017, các nhà nghiên cứu của Google đã giới thiệu kiến trúc Tranformer trong bài báo "Attention Is All You Need". Tiếp đến, năm 2018, học giới thiệu BERT và nó cũng nhanh chóng trở nên phổ biến.

Nhìn về thời gian xa hơn, ý tưởng về LLM được nhiều bên thừa nhận xuất hiện từ năm 1960, với sự ra đời của Elize (một số tài liệu ghi năm 1962). Đây là chatbot đầu tiên trên thế giới, được phát triển bởi nhà nghiên cứu của MIT, Joseph Weizenbaum. Eliza đánh dấu sự khởi đầu của nghiên cứu về xử lý ngôn ngữ tự nhiên (NLP), cung cấp nền tảng cho các LLM phức tạp hơn sau này.

Hơn 30 năm sau, vào năm 1997, Long short-term memory (LSTM, tạm dịch: Bộ nhớ dài - ngắn hạn) ra đời. Sự ra đời của chúng dẫn đến các mạng nơ-ron kết nối sâu hơn và phức tạp hơn, giúp xử lý lượng dữ liệu lớn hơn. Bộ công cụ CoreNLP của Stanford, được giới thiệu vào năm 2010, là giai đoạn tăng trưởng tiếp theo cho phép các nhà phát triển thực hiện phân tích cảm xúc và nhận dạng thực thể được đặt tên.

Và khi khả năng tính toán tăng lên và các tập dữ liệu trở nên lớn hơn, các mô hình này ngày càng phát triển, đỉnh cao như chúng ta đang thấy ngày nay. Các mô hình này, chẳng hạn như GPT của OpenAI, đã đặt ra những tiêu chuẩn mới cho khả năng hiểu và tạo ngôn ngữ của máy móc. Từ mức độ đáp ứng, sự phức tạp, tinh tế trong nội dung đến khả năng mô phỏng "giống người" đã đạt đến mức chưa từng có trước đây.

📌 Liên quan: Dòng thời gian của trí tuệ nhân tạo AI từ năm 1950 đến 2024

Các thành phần chính của mô hình ngôn ngữ lớn LLM

Các thành phần chính của LLM hay kiến trúc của LLM bao gồm nhiều lớp mạng nơ-ron như: recurrent layers, feedforward layers, embedding layers, and attention layers. Chúng đóng vai trò quan trọng trong xử lý, học và tạo ngôn ngữ để đáp ứng nhu cầu của người dùng.

Embedding layer

Embedding layer (lớp nhúng) là bước đầu tiên trong quá trình xử lý của LLM. Chức năng chính của lớp này là chuyển đổi các từ, văn bản đầu vào (hay ccó thể gọi là token) thành số, cho phép mô hình xử lý ngôn ngữ theo phương pháp toán học. Phần này của mô hình ngôn ngữ lớn cũng đóng vai trò nắm bắt ý nghĩa ngữ nghĩa và cú pháp đầu vào, dựa vào đó, mô hình có thể hiểu ngữ cảnh, mong muốn của người dùng

Mỗi từ trong văn bản đầu vào được liên kết với một vectơ dày đặc. Các từ có ý nghĩa tương tự được đặt gần nhau trong không gian vectơ, giúp mô hình nhanh chóng nắm bắt mối quan hệ giữa các thuật ngữ và ngữ cảnh, sắc thái của văn bản.

Feedforward network layers (FFN)

Feedforward network layers thường là một phần của khối tranformers, chịu trách nhiệm biến đổi phi tuyến tính cho các embedding vector đầu vào, giúp các mô hình tạo ra liên kết kết giữa dữ liệu đầu vào và đầu ra, góp phần tạo ra văn bản phù hợp với ngữ cảnh và giống con người nhất có thể.

Đây là bước quan trọng giúp mô hình học và tạo ra nhiều mẫu ngôn ngữ khác nhau.

Recurrent layer

Không phải tất cả các mô hình ngôn ngữ lớn đều sử dụng recurrent layer, nhưng những mô hình sử dụng chúng hưởng lợi từ khả năng xử lý các chuỗi dữ liệu. Các lớp này cho phép diễn giải văn bản đầu vào theo trình tự, duy trì các thông tin đã thấy trước đó. Điều này được thực hiện thông qua các vòng lặp cho phép thông tin tồn tại, giúp các lớp này đặc biệt hiệu quả khi thực hiện các nhiệm vụ có tính tuần tự, như duy trì tính liên tục của cuộc đối thoại. mô hình

Attention layer

Attention layer hay attention mechanism cho phép mô hình tập trung có chọn lọc vào các phần khác nhau có liên quan nhất đến nhiệm vụ cụ thể trong văn bản đầu vào. Sự tập trung có chọn lọc này cho phép mô hình tạo ra văn bản mạch lạc và phù hợp với ngữ cảnh bám sát với nhiệm vụ, yêu cầu cụ thể từ người dùng.

Cơ chế này hoạt động bằng cách gán trọng số cho mỗi phần dữ liệu đầu vào, điều này giúp hệ thống nhận thức tầm quan trọng của các yếu tố trong việc tạo ra, thực hiện các bước tiếp theo. Bằng cách này, mô hình có thể tập trung vào các điểm quan trọng, giảm bớt sự quan tâm hoặc lược bỏ những phần không quan trọng trong dữ liệu đầu vào.

Transformers

Xương sống của các mô hình ngôn ngữ lớn. Tranformers dựa nhiều vào Attention layer để xử lý văn bản. Chúng bao gồm một kiến trúc được biểu diễn bởi các cặp mã hóa và bộ giải mã. Khả năng xử lý song song của transformers cho phép hệ thống học tập hiệu quả hơn và giúp các mô hình này nắm bắt các mối quan hệ phức tạp và ý nghĩa tinh tế trong dữ liệu ngữ cảnh.

Điều này làm giúp LLM đặc biệt giỏi trong việc hiểu và tạo ra ngôn ngữ con người.

Các mô hình ngôn ngữ lớn hoạt động như thế nào

Mô hình ngôn ngữ lớn hoạt động bằng cách sử dụng mạng nơron sâu, thường là dựa trên kiến trúc transformer. Tuân theo quy trình bao gồm mã hóa đầu vào, giải mã và dự đoán đầu ra. Nó nhúng từ, biểu diễn mỗi từ dưới dạng vectơ số. Và sử dụng lớp transformer để hiểu mối quan hệ giữa các từ.

Nhưng trước khi một mô hình ngôn ngữ lớn có thể trả lời các yêu cầu đầu vào của người dùng, chúng cần được huấn luyện để thực hiện các chức năng tổng quát và từ từ tinh chỉnh để thực hiện nhiệm vụ cụ thể.

Như đã đề cập ở các thành phần chính của LLM, thì mô hình ngôn ngữ lớn thực hiện các phép toán tuyến tính và phi tuyến tính. Thông qua các lớp và quá trình huấn luyện, chúng có thể hiểu và tạo ra ngôn ngữ tự nhiên. Hoặc thực hiện các chuỗi nhiệm vụ theo yêu cầu cụ thể.

Huấn luyện

LLM được huấn luyện bằng cách nạp dữ liệu từ các nguồn, tập dữ liệu lớn như Google, Wikipedia, Github hoặc các nguồn khác. Đây cũng là điểm cốt lõi của LLM, kích thước của tập dữ liệu càng lớn, dữ liệu đầu ra càng chất lượng.

Ở giai đoạn này, mô hình ngôn ngữ lớn tham gia vào quá trình học không giám sát, có nghĩa hệ thống sẽ tự xử lý các dữ liệu được cung cấp. Trong quá trình này, thuật toán AI của LLM có thể học ý nghĩa của từ và mối quan hệ giữa các từ, giữa các từ trong câu, cụm từ, câu với ngữ cảnh cụ thể. Ví dụ, mô hình sẽ học hiểu nghĩa của từ "Đúng" và từ trái nghĩa với Đúng là "Sai".

Bằng cách chắt lọc từ kho dữ liệu khổng lồ, mô hình có thể hiểu được nhiều ngôn ngữ và có kiến thức về nhiều chủ đề khác nhau.

Tinh chỉnh

Hiểu đơn giản, đây là giai đoạn cần can thiệp để giúp tối ưu hóa hiệu suất của các nhiệm vụ cụ thể.

Prompt-tuning

Thực hiện các chức năng gần như giai đoạn tinh chỉnh, nhưng tập trung hơn vào prompt được nhận. Nó giúp mô hình đáp ứng các yêu cầu cụ thể thông qua một vài gợi ý được cung cấp cho LLM. Prompt-tuning hỗ trợ quá trình đào tạo LLM thông qua các ví dụ bạn nhập vào. Điều này giúp hệ thống hiểu hơn về dữ liệu nhận được hay yêu cầu của bạn cũng như mức độ đáp ứng.

Ví dụ cơ bản: Tôi thích trời mưa. Đây là cảm xúc tích cực. Tôi ghét trời mưa. Đây là cảm xúc tiêu cực.

Ngược lại, zero-shot prompting không sử dụng ví dụ để dạy mô hình ngôn ngữ cách phản ứng với đầu vào. Thay vào đó, nó đặt câu hỏi dưới dạng "Cảm xúc trong câu 'Tôi ghét thời tiết mưa..." Nó chỉ rõ nhiệm vụ mà mô hình ngôn ngữ cần thực hiện, nhưng không cung cấp các ví dụ giải quyết vấn đề

Mô hình ngôn ngữ lớn được đào tạo, huấn luyện như thế nào?

Kiến trúc của LLM chủ yếu bao gồm nhiều lớp mạng nơ-ron. Các mạng này gồm nhiều điểm và lớp khác nhau. Mỗi điểm trong một lớp sẽ kết nối với tất cả các điểm trong lớp tiếp theo với trọng số khác nhau. Quá trình huấn luyện được thực hiện bằng cách nạp lượng lớn dữ liệu chất lượng cao vào hệ thống. Trong quá trình huấn luyện, mô hình sẽ điều chỉnh giá trị các tham số theo từng bước cho đến khi mô hình dự đoán chính xác yêu cầu cụ thể dựa trên chuỗi dữ liệu đầu vào trước đó.

Điều này được thực hiện thông qua kỹ thuật tự học, chúng giúp các mô hình ngôn ngữ lớn có thể tự động điều chỉnh các tham số để tối ưu hóa khả năng đáp ứng cũng như dễ dàng thích nghi với nhiều nhiệm vụ, yêu cầu khác biệt. Ba mô hình tự học phổ biến hiện nay gồm: zero-shot learning, few-shot learning, fine-tuning. Mỗi mô hình có một ưu nhược điểm khác nhau, chúng ta sẽ tìm hiểu kỹ hơn về điều này ở các bài tiếp theo.

Các trường hợp sử dụng mô hình ngôn ngữ lớn

Các mô hình ngôn ngữ lớn LLM có thể được sử dụng cho nhiều mục đích như:

Truy xuất thông tin: Bing và Google sẽ là 2 công cụ bạn nghĩ đến đến đầu tiên để đại diện cho việc truy xuất thông tin. Các công cụ tìm kiếm cũng được hưởng lợi nhiều nhất từ LLM, chúng có thể hiểu và diễn giải các truy vấn bằng ngôn ngữ tự nhiên, cung cấp kết quả tìm kiếm chính xác hơn và phù hợp với ngữ cảnh.

Phân tích cảm xúc: là một ứng dụng của xử lý ngôn ngữ tự nhiên. Các mô hình ngôn ngữ lớn LLM cho phép các doanh nghiệp phân tích cảm xúc dựa trên dữ liệu văn bản.

Tạo văn bản, đoạn văn: các mô hình ngôn ngữ lớn đứng sau GenAI, chúng có thể tạo văn bản, trả lời dựa trên văn bản đầu vào. Ví dụ: viết cho tôi bài văn miêu tả về chiếc xe đạp màu xanh.

Tạo mã, code: Giống như tạo văn bản, tạo mã là một ứng dụng của AI tạo sinh. Các mô hình ngôn ngữ lớn hiểu các mẫu, điều này cho phép chúng tạo ra mã, đoạn mã phù hợp.

Chatbot và Voicebot, đàm thoại: Các mô hình ngôn ngữ lớn cho phép các chatbot hoặc AI đàm thoại diễn giải ý nghĩa của truy vấn hoặc voice đầu vào, từ đó tương tác với khách hàng, trả lời hoặc đưa ra các phản hồi tương ứng.

Và trên thực tế, chung ta có thể thấy LLM được ứng dụng trong rất nhiều lĩnh vực khác nhau:

Công nghệ

Các mô hình ngôn ngữ lớn LLM được ứng dụng rất nhiều trong lĩnh vực công nghệ, từ việc phản hồi các truy vấn, tóm tắt, cập nhật thông tin, check lỗi đến hỗ trợ các nhà phát triển, lập trình viết code.

Dịch vụ khách hàng

LLM có thể xây dựng chatbot, trợ lý ảo để xử lý yêu cầu từ khách hàng, hỗ trợ giải đáp nhanh hoặc giải quyết các vấn đề cụ thể một cách hiệu quả và giống con người. Điều này đóng vai trò lớn trong việc tối ưu vận hành từ doanh nghiệp.

Chăm sóc sức khỏe

Các mô hình ngôn ngữ lớn có khả năng hiểu protein, phân tử, DNA và RNA. Điều này cho phép LLM hỗ trợ phát triển vắc-xin, tìm cách chữa bệnh và đóng góp cải thiện các loại thuốc. LLM cũng được sử dụng làm chatbot y tế để thực hiện tiếp nhận bệnh nhân hoặc chẩn đoán cơ bản. Tuy vậy điều này vẫn còn gặp nhiều khó khăn vì tính đạo đức và trách nhiệm cụ thể.

Marketing

Marketer sử dụng khá thường xuyên các công cụ được phát triển dựa trên LLM. Từ viết, tạo ý tưởng cho đến phân tích dữ liệu, gợi ý chiến lược cho các campaign. Hay chỉ đơn giản là dịch thuật, check lỗi chính tả.

Dịch thuật

Một trong những ứng dụng phổ biến nhất của LLMs là có thể dịch văn bản với độ chính xác cao, cho phép giao tiếp rõ ràng hơn, giảm bớt rào cản ngôn ngữ và làm cho nội dung trở nên dễ tiếp cận trên toàn cầu.

Ngoài ra, LLM còn có tiềm năng ứng dụng vô hạn trong nhiều lĩnh vực khác như tài chính, phân tích dữ liệu,...

Tại sao các mô hình ngôn ngữ lớn quan trọng trong kinh doanh?

Bằng cách tự động hóa, hỗ trợ chăm sóc khách hàng, dịch vụ khách hàng đến phân tích dữ liệu, hỗ trợ ban quản lý đưa qua quyết định rõ ràng, LLM cho phép các doanh nghiệp đẩy nhanh tốc độ phát triển, giảm chi phí liên quan đến nguồn nhân lực, vận hành. Hay thậm chí là cá nhân hóa trải nghiệm khách hàng trong vài lĩnh vực cụ thể. Điều này cũng giúp doanh nghiệp nhanh chóng tiếp cận thông tin, đánh giá, phân tích các dữ liệu quan trọng, hỗ trợ quá trình ra quyết định.

Ngoài ra, khả năng đáp ứng cao của LLM trên nhiều lĩnh vực khác nhau cũng giúp mô hình này được áp dụng cho nhiều lĩnh vực chuyên biệt, cần sự chính xác và hỗ trợ chuyên môn nhanh chóng. Đáp ứng tốt hơn nhu cầu càng ngày càng cao của khách hàng và thị trường.

Theo một cách nào đó, LLM là công cụ giúp tối ưu quy trình, tinh gọn đội ngũ, giúp các đội nhóm, doanh nghiệp hoạt động nhanh chóng và hiệu quả. Tuy vậy, việc cơ sở dữ liệu quá lớn cùng khả năng đáp ứng tốt cũng khiến các doanh nghiệp lo ngại khi ứng dụng, đặc biệt khi điều này liên quan trực tiếp đến chi phí. Vì vậy trong vài trường hợp cụ thể, các doanh nghiệp có thể ưu tiên lựa chọn các mô hình ngôn ngữ nhỏ SLMs.

Tương lai của mô hình ngôn ngữ lớn

Sự ra đời của các mô hình ngôn ngữ lớn như ChatGPT, Claude 2 và Llama 2 với khả năng trả lời các câu hỏi và tạo ra văn bản đã mở ra những tiềm năng thú vị trong tương lai. Chậm nhưng chắc chắn, LLM đang dần đạt được hiệu quả rõ ràng với khả năng "giống người". Dưới đây là một số góc nhìn về tương lai của LLM

Khả năng thích ứng

Dù rất tuyệt vời, nhưng hiện tại, LLM không hoàn hảo khi hoàn toàn có thể mắc sai lầm, khi cần đảm bảo trách nghiệm cũng như tính mới của nội dung, dữ liệu đầu ra. Điều này vẫn đang được cải thiện từng bước ở các phiên bản tiếp theo, giúp giảm bớt ý kiến chủ quan hay các câu trả lời không chính xác.

Dữ liệu đào tạo

Một số mô hình ngôn ngữ lớn vẫn đang đào tạo bằng cách sử dụng văn bản, trong khi đó, một số đã bắt đầu sử dụng dữ liệu đầu vào ở dạng hình ảnh, âm thanh, video. Hình thức này giúp mô hình học nhanh hơn nhưng vẫn như trên, tính chính xác của dữ liệu vẫn là điều đáng lo ngại.

Hỗ trợ các AI giao tiếp

Việc LLM ngày càng phát triển chắc chắn sẽ giúp cả thiện hiệu năng của các trợ lý ảo như Alexa, GG Assistant, Siri,... hoặc giúp một số AI chat bot, voice hoạt động tốt hơn, chính xác hơn và giống người hơn cho các câu các lệnh phức tạp.

Một trong những xu hướng quan trọng là tăng cường khả năng tương tác và đối thoại của AI LLM. Hiện tại, các mô hình ngôn ngữ lớn chủ yếu được sử dụng để tạo ra văn bản một chiều. Nhưng trong tương lai có thể được phát triển để có khả năng đối thoại tương tác với con người một cách tự nhiên.

Đồng thời, cũng sẽ được chú trọng vào việc đảm bảo tính minh bạch, an toàn trong việc xử lý thông tin, tạo đầu ra chính xác.

Ngoài ra, mô hình ngôn ngữ lớn trong tương lai sẽ có xu hướng tập trung vào tối ưu hóa. Để có thể triển khai trên nhiều ứng dụng và thiết bị khác nhau.

Ví dụ về các mô hình ngôn ngữ lớn phổ biến

Chắc bạn đã nghe về Chat GPT, Copilot, Gemini. Đây chính là những ví dụ phổ biến nhất về mô hình ngôn ngữ lớn.

Các mô hình LLM phổ biến khác bao gồm:

PaLM: Mô hình ngôn ngữ Pathways (PaLM) mô hình ngôn ngữ mà Google đang triển khai để đưa khả năng AI vào tất cả các sản phẩm của mình, bao gồm Gmail, Google Docs và Bard (hay Gemini hiện tại).

Vào tháng 5/2023, Google đã công bố PaLM 2, sản phẩm tiếp theo của PaLM. PaLM 2 có 4 phiên bản và hỗ trợ hơn 100 ngôn ngữ khác nhau. Mô hình có khả năng thực hiện nhiều tác vụ khác nhau, bao gồm tóm tắt, trả lời câu hỏi, tạo hình ảnh, âm thanh hoặc video, tạo văn bản hoặc đáp ứng nhiều yêu cầu khác biệt.

BERT: Mô hình ngôn ngữ Bidirectional Encoder Representations from Transformers (BERT) cũng được phát triển bởi Google. Đây là một mô hình transformer, có thể hiểu ngôn ngữ tự nhiên và trả lời các câu hỏi.

GPT: Có lẻ đây là mô hình ngôn ngữ lớn nổi tiếng nhất. Được phát triển bởi OpenAI, GPT có thể được tinh chỉnh để thực hiện nhiều tác vụ khác nhau.

Trên đây là những thông tin, kiến thức tổng quát về mô hình ngôn ngữ lớn LLM. Bài viết tập trung giải đáp các câu hỏi, thắc mắc về LLM, từ khái niệm LLM là gì đến cách thức hoạt động và ví dụ cụ thể. Hẹn gặp lại các bạn ở bài viết tiếp theo, nơi chúng ta sẽ tìm hiểu về lợi ích, khó khăn và thách thức của LLM.

Mục lục

LLM (Large Language Model) là gì?

Sự khác biệt giữa LLM và GenAI

Các thành phần chính của mô hình ngôn ngữ lớn LLM

Các mô hình ngôn ngữ lớn hoạt động như thế nào

Mô hình ngôn ngữ lớn được đào tạo, huấn luyện như thế nào?

Các trường hợp sử dụng mô hình ngôn ngữ lớn

Tại sao các mô hình ngôn ngữ lớn quan trọng trong kinh doanh?

Bài viết cùng chủ đề

Điện toán đám mây (Cloud Computing) là gì? Khái niệm, phân loại và lợi ích

23/02/2026

23/02/2026 Góc nhìn: Thực trạng chuyển đổi số cấp xã phường hiện nay

11/02/2026

11/02/2026 Những khó khăn trong chuyển đổi số cấp xã phường

05/02/2026

05/02/2026 Một số giải pháp trong công tác chuyển đổi số cấp xã, phường

26/01/2026

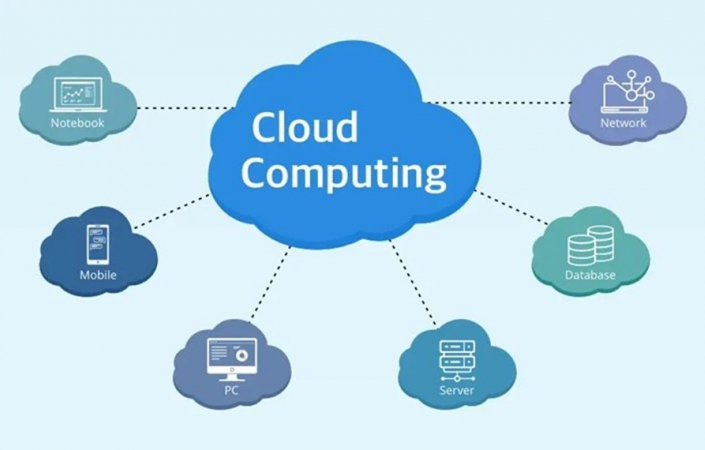

26/01/2026 Virtual Twin: Vai trò then chốt trong đổi mới thiết kế, chế tạo

23/01/2026

23/01/2026 So sánh Local AI và AI on Cloud: Giải pháp nào tốt nhất cho doanh nghiệp?

15/01/2026

15/01/2026 GRPO là gì? Thuật toán huấn luyện đằng sau DeepSeek

13/01/2026

13/01/2026 Chuyển đổi số cấp xã, phường: Nền tảng của chính quyền số

24/12/2025

24/12/2025 Local AI là gì? Ứng dụng và lợi ích khi triển khai

23/12/2025

23/12/2025