Đăng ký nhận báo giá

Mô hình ngôn ngữ nhỏ SLM là gì? Các thông tin cơ bản về SLMs

.jpg)

Trong khi các mô hình ngôn ngữ lớn (LLM) chiếm lĩnh các tiêu đề báo, một xu hướng khác đang âm thầm lan rộng.

Các mô hình ngôn ngữ nhỏ (SLM) đang dần chiếm được lòng tin của doanh nghiệp nhờ vào khả năng tiếp cận có chọn lọc, tập trung, hiệu quả và tiết kiệm chi phí hơn để triển khai AI.

Vậy điều gì đã khiến SLM trở thành “át chủ bài” trong chiến lược AI thời gian gần đây? Tìm kiếm câu trả lời sau khi giải mã toàn cảnh về Small Language Models, từ định nghĩa, cơ chế hoạt động đến ứng dụng thực tế trong bài viết này.

Small Language Models (SLM) là gì?

Small Language Models (tạm dịch: Mô hình ngôn ngữ nhỏ) là mô hình trí tuệ nhân tạo có khả năng xử lý, hiểu và tạo nội dung ngôn ngữ tự nhiên. Đúng như tên gọi, SLM có quy mô và phạm vi nhỏ hơn so với mô hình ngôn ngữ lớn.

Về mặt kích thước, các tham số SLM dao động từ vài triệu đến vài tỷ, trái ngược với LLM có hàng trăm tỷ hoặc thậm chí hàng nghìn tỷ tham số. Chẳng hạn như GPT-4 có thể sở hữu hơn 175 tỷ tham số trong khi SLM thường chỉ dao động từ hàng chục triệu đến dưới 30 tỷ tham số.

Kiến trúc thu gọn này cho phép SLM thực hiện các tác vụ xử lý ngôn ngữ tự nhiên trong các trường hợp cụ thể, chẳng hạn như chatbot dịch vụ khách hàng và trợ lý ảo, với công suất tính toán ít hơn đáng kể so với các đối tác lớn hơn. Được đào tạo trên các tập dữ liệu tập trung, vì vậy SLM hoạt động hiệu quả trong các nhiệm vụ phân tích phản hồi của khách hàng, tạo mô tả sản phẩm hoặc thậm chí xử lý thuật ngữ chuyên ngành.

Mô hình ngôn ngữ nhỏ SLM yêu cầu ít bộ nhớ và sức mạnh tính toán, khiến chúng trở nên lý tưởng cho các môi trường hạn chế về tài nguyên như: ứng dụng di động hoặc thậm chí cho các tình huống suy luận AI phải được thực hiện ngoại tuyến mà không cần mạng dữ liệu.

Theo nhà phân tích Gartner, các mô hình ngôn ngữ nhỏ (SLM) cung cấp một giải pháp thay thế có khả năng tiết kiệm chi phí cho việc phát triển và triển khai trí tuệ nhân tạo tạo sinh (GenAI) vì chúng dễ tinh chỉnh hơn, dễ kiểm soát hơn và hiệu quả hơn trong các trường hợp cụ thể.

Cụ thể, thay vì cung cấp kiến thức đa dạng và rộng lớn như các LLM thông thường, SLM theo lĩnh vực tập trung vào một loại kiến thức chuyên biệt. Các mô hình này được đào tạo sâu trong một lĩnh vực cụ thể, giúp đưa ra phản hồi chính xác hơn và phù hợp với vai trò của người dùng, ví dụ: trả lời câu hỏi của Giám đốc Marketing (CMO) sẽ khác với câu hỏi từ Giám đốc Tài chính (CFO).

Small Language Models được "thu nhỏ" như thế nào?

Quá trình thu nhỏ mô hình ngôn ngữ bao gồm một số kỹ thuật nhằm mục đích giảm kích thước của mô hình mà không ảnh hưởng quá nhiều đến hiệu suất:

- Knowledge Distillation: Đào tạo mô hình "học sinh" nhỏ hơn bằng cách sử dụng kiến thức được chuyển giao từ mô hình "giáo viên" lớn hơn.

- Pruning: Loại bỏ các tham số dư thừa hoặc ít quan trọng trong kiến trúc mạng nơ-ron.

- Quantization: Giảm độ chính xác của các giá trị số được sử dụng trong phép tính (ví dụ chuyển đổi số dấu phẩy động sang số nguyên).

Hiểu được quá trình thu nhỏ của SLM sẽ giúp bạn dễ dàng nắm bắt được các thông tin hoạt động của mô hình.

Mô hình ngôn ngữ nhỏ hoạt động như thế nào?

Mô hình ngôn ngữ lớn LLM đóng vai trò là cơ sở cho SLM. Giống như các mô hình ngôn ngữ lớn, các mô hình ngôn ngữ nhỏ sử dụng kiến trúc dựa trên mạng nơ-ron được gọi là mô hình biến áp. Biến áp đã trở thành nền tảng trong xử lý ngôn ngữ tự nhiên (NLP) và hoạt động như các khối xây dựng của các mô hình như biến áp được đào tạo trước tạo ra (GPT).

Dưới đây là cách hoạt động cơ bản của SLM:

- Bộ mã hóa chuyển đổi chuỗi đầu vào thành chuỗi số, gọi là token (thường là từ, cụm từ, hoặc ký tự) để nắm bắt ngữ nghĩa và vị trí của mã thông báo trong chuỗi đầu vào.

Ví dụ: “Xin chào” → [10123, 54321]

- Biểu diễn token dưới dạng vector nhiều chiều (embedding) để mô hình hiểu và xử lý.

- Dự đoán từ tiếp theo (Next-token prediction): Mô hình học cách dự đoán từ kế tiếp dựa trên ngữ cảnh từ các từ trước đó. Mỗi lớp mạng trong mô hình (gọi là Transformer block) phân tích mối quan hệ giữa các token (self-attention) để hiểu ngữ nghĩa.

- Mô hình tạo ra chuỗi văn bản bằng cách sinh token tiếp theo một cách tuần tự cho đến khi kết thúc câu hoặc chạm ngưỡng giới hạn độ dài.

Ví dụ về SLM

Một số mô hình ngôn ngữ nhỏ nhưng mạnh mẽ đã xuất hiện, chứng minh rằng kích thước không phải là tất cả. VR360 đã tổng hợp một số ví dụ về các mô hình ngôn ngữ nhỏ có phạm vi từ 1-4 tỷ tham số:

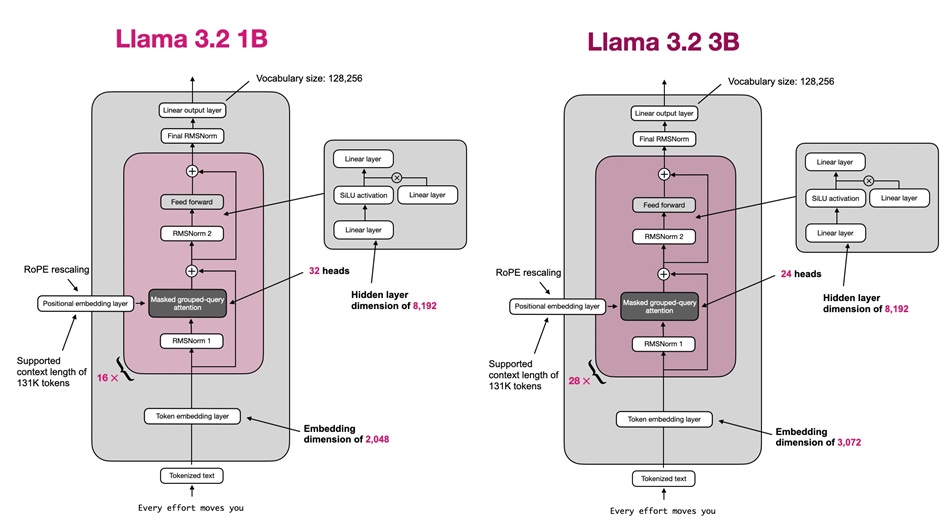

Llama3.2-1B: Llama gồm các mô hình ngôn ngữ lớn đa ngôn ngữ LLM. Tuy nhiên, phiên bản Llama 3.2 -1B nhỏ hơn đáng kể so với mô hình 405 tỷ tham số của Llama. Biến thể 1 tỷ tham số do Meta phát triển được tối ưu hóa cho các thiết bị biên.

Qwen2.5-1.5B: Một mô hình từ Alibaba được thiết kế cho các ứng dụng đa ngôn ngữ với 1,5 tỷ tham số .

DeepSeeek-R1-1.5B: Mô hình lý luận thế hệ đầu tiên của DeepSeek được chắt lọc từ Qwen2.5 với 1,5 tỷ tham số.

SmolLM2-1.7B: Từ HuggingFaceTB, một mô hình ngôn ngữ nhỏ với 1,7 tỷ tham số. Được đào tạo trên các tập dữ liệu mở chuyên biệt (FineMath, Stack-Edu và SmolTalk).

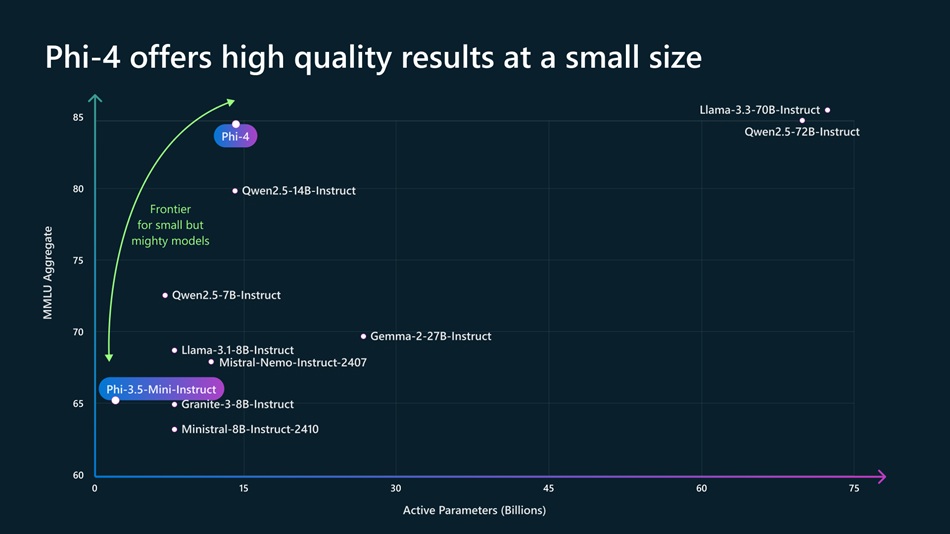

Phi-3.5-Mini-3.8B: Mô hình mở nhỏ nhưng có sức mạnh của Microsoft với 3,8 tỷ tham số được tối ưu hóa cho suy luận và tạo mã.

Gemma3-4B: Được phát triển bởi Google DeepMind, mô hình 4 tỷ tham số nhẹ nhưng mạnh mẽ này có nhiều ngôn ngữ và đa phương thức.

Vào tháng 12 năm 2024, Microsoft đã phát hành SLM mới nhất trong bộ Phi của mình, Phi-4, được cho là "vượt trội hơn các mô hình tương đương và lớn hơn về khả năng suy luận liên quan đến toán học" cũng như có khả năng thực hiện xử lý ngôn ngữ thông thường.

Ưu điểm của mô hình ngôn ngữ nhỏ

Tại sao ngày càng nhiều doanh nghiệp, startup hay nhà phát triển lựa chọn SLM thay vì các mô hình AI cỡ lớn? Dưới đây là những lợi thế nổi bật khiến SLM trở thành giải pháp lý tưởng trong kỷ nguyên AI tinh gọn.

- Yêu cầu tính toán thấp: SLMS đủ “nhẹ” để vận hành trực tiếp trên laptop, thiết bị di động hoặc thiết bị biên, không cần máy chủ mạnh mẽ.

- Tiêu thụ năng lượng thấp hơn: Nhờ cấu trúc tinh gọn, SLM giảm đáng kể lượng điện năng tiêu thụ, góp phần thân thiện với môi trường.

Theo Hiệp hội Nhà khoa học Dữ liệu (ADaSci), chỉ riêng việc đào tạo GPT-3 với 175 tỷ tham số đã tiêu thụ khoảng 1.287 MWh (megawatt-giờ) điện. Tương đương mức tiêu thụ năng lượng của một hộ gia đình Mỹ trung bình trong 120 năm.

Trong khi đó, việc triển khai hoàn chỉnh một mô hình ngôn ngữ nhỏ với 7 tỷ tham số cho 1 triệu người dùng chỉ tiêu tốn 55,1 MWh - chưa đến 5% so với mô hình lớn.

- Suy luận nhanh: Các mô hình nhỏ hơn xử lý nhanh, phản hồi mượt, lý tưởng cho các ứng dụng real-time như chatbot, trợ lý ảo, app chăm sóc khách hàng.

- AI trên thiết bị: Không cần kết nối internet hay đám mây, SLM cho phép xử lý offline, giúp nâng cao quyền riêng tư và bảo mật dữ liệu.

- Triển khai rẻ hơn: Chi phí phần cứng và dịch vụ thấp, giúp AI tiếp cận dễ hơn với doanh nghiệp vừa và nhỏ, hay đội ngũ phát triển nội bộ.

- Khả năng tùy chỉnh: Dễ dàng tinh chỉnh cho các nhiệm vụ cụ thể theo từng lĩnh vực (ví dụ: phân tích tài liệu pháp lý).

Hạn chế của mô hình ngôn ngữ nhỏ

Tất nhiên, tương tự như bất kỳ công nghệ nào, SLM cũng đi kèm những hạn chế và giới hạn. Quan trọng là hiểu rõ để chọn đúng giải pháp cho bài toán của bạn.

- Phạm vi hẹp: SLM hoạt động tốt trong phạm vi dữ liệu được huấn luyện, nhưng sẽ hạn chế khả năng tổng quát nếu ứng dụng ngoài lĩnh vực đó.

- Rủi ro thiên kiến: Nếu không kiểm soát tốt dữ liệu huấn luyện, thiên kiến trong dữ liệu nhỏ có thể bị khuếch đại, ảnh hưởng đến độ tin cậy đầu ra.

- Giảm độ phức tạp: Với nhiệm vụ yêu cầu hiểu sâu ngữ cảnh hoặc xử lý đa tầng, SLM có thể không mạnh bằng LLM.

- Ít mạnh mẽ hơn: Chúng dễ mắc lỗi hơn trong các tình huống mơ hồ hoặc khi phải đối mặt với các đầu vào đối nghịch.

Các trường hợp sử dụng tiềm năng cho các mô hình ngôn ngữ nhỏ

SLM có nhiều khả năng ứng dụng thực tế trong nhiều trường hợp khác nhau:

Chatbot và Trợ lý ảo: Được đào tạo chuyên sâu trên các tập dữ liệu tương tác, SLM có thể xử lý nhanh chóng các yêu cầu phổ biến của khách hàng, từ việc trả lời câu hỏi thường gặp đến hỗ trợ sự cố đơn giản. Tối ưu cho các doanh nghiệp cần một trợ lý AI nhẹ nhưng đủ nhanh và chính xác.

Code: Các mô hình như Phi-3.5 Mini hỗ trợ các nhà phát triển trong việc viết và gỡ lỗi mã, đề xuất cải tiến và tự động hóa các tác vụ mã hóa lặp đi lặp lại.

Tóm tắt & sáng tạo nội dung: Các mô hình Llama 3.2 1B và 3B có thể được sử dụng để tóm tắt các cuộc thảo luận trên điện thoại thông minh và tạo các mục hành động như sự kiện lịch. Tương tự như vậy, Gemini Nano có thể tóm tắt các bản ghi âm và bản ghi chép các cuộc trò chuyện.

AI tạo sinh: Các mô hình nhỏ gọn có thể được triển khai để hoàn thiện và tạo ra văn bản và mã phần mềm. Ví dụ, các mô hình granite-3b-code-instruct và granite-8b-code-instruct có thể được sử dụng để tạo, giải thích và dịch mã từ lời nhắc ngôn ngữ tự nhiên.

Dịch ngôn ngữ: Nhiều mô hình ngôn ngữ nhỏ có nhiều ngôn ngữ và đã được đào tạo bằng các ngôn ngữ khác ngoài tiếng Anh, do đó chúng có thể dịch nhanh giữa các ngôn ngữ. Do khả năng hiểu ngữ cảnh, chúng có thể tạo ra các bản dịch gần như chính xác, giữ nguyên sắc thái và ý nghĩa của văn bản gốc.

Bảo trì dự đoán: Các mô hình tinh gọn đủ nhỏ để triển khai trực tiếp trên các thiết bị biên cục bộ như cảm biến hoặc thiết bị IoT. Điều này có nghĩa là các nhà sản xuất có thể coi SLM như các công cụ thu thập dữ liệu từ các cảm biến được lắp đặt trong máy móc và thiết bị và phân tích dữ liệu đó theo thời gian thực để dự đoán nhu cầu bảo trì.

Small Language Models (SLM) là bước tiến quan trọng hướng tới AI hiệu quả, dễ tiếp cận và tiết kiệm chi phí. Cung cấp các giải pháp thực tế cho các doanh nghiệp, nhà phát triển và nhà nghiên cứu đang tìm kiếm AI mạnh mẽ mà không phải chịu gánh nặng tính toán của LLM.

Kết luận

Mô hình ngôn ngữ nhỏ SLMs đại diện cho một bước quan trọng, hướng đến tận dụng AI một các hiệu quả, tiết kiệm. Điều này cũng mở ra cho các doanh nghiệp hướng tiếp cận mới hơn mà không phải chịu gánh nặng chi phí quá lớn như LLMs.

Trên đây là những thông tin tổng quát về mô hình ngôn ngữ nhỏ SLM. Hẹn gặp lại bạn ở bài viết tiếp theo, nơi chúng ta sẽ tìm hiểu về những điểm khác biệt giữa SLM và LLM.

Bài viết cùng chủ đề

Điện toán đám mây (Cloud Computing) là gì? Khái niệm, phân loại và lợi ích

23/02/2026

23/02/2026 Góc nhìn: Thực trạng chuyển đổi số cấp xã phường hiện nay

11/02/2026

11/02/2026 Những khó khăn trong chuyển đổi số cấp xã phường

05/02/2026

05/02/2026 Một số giải pháp trong công tác chuyển đổi số cấp xã, phường

26/01/2026

26/01/2026 Virtual Twin: Vai trò then chốt trong đổi mới thiết kế, chế tạo

23/01/2026

23/01/2026 So sánh Local AI và AI on Cloud: Giải pháp nào tốt nhất cho doanh nghiệp?

15/01/2026

15/01/2026 GRPO là gì? Thuật toán huấn luyện đằng sau DeepSeek

13/01/2026

13/01/2026 Chuyển đổi số cấp xã, phường: Nền tảng của chính quyền số

24/12/2025

24/12/2025 Local AI là gì? Ứng dụng và lợi ích khi triển khai

23/12/2025

23/12/2025